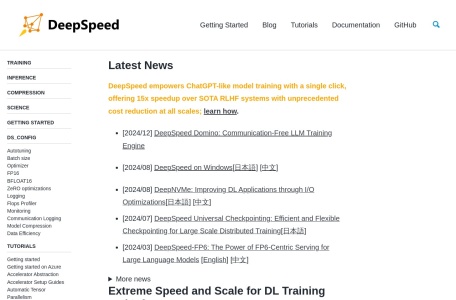

DeepSpeed is a deep learning optimization library that makes distributed training easy, efficient, and effective.

DeepSpeed的概述

DeepSpeed是一个由微软开发并维护的开源深度学习优化库。其主要目的是提高大规模模型训练的效率和可扩展性,帮助开发者更有效率地管理及优化大模型的训练、部署任务。DeepSpeed通过创新的算法和技术,降低了训练超大规模模型的复杂性和资源需求,使得深度学习训练变得更快、更高效。

DeepSpeed的主要功能

DeepSpeed提供了多种功能来优化深度学习模型的训练和推理过程,主要包括:

1. 大规模并行训练:支持数据并行、模型并行和混合并行,使超大模型的多GPU训练成为可能。

2. 优化内存管理:采用ZeRO(Zero Redundancy Optimizer)技术,通过分阶段优化(如ZeRO-3),减少冗余计算和内存占用,让大模型在有限硬件上运行。

3. 混合精度训练:结合FP16的快速计算和FP32的数值稳定性,提升计算效率。

4. 高效推理:优化推理性能,支持低延迟和高吞吐量场景。

5. 易集成:兼容PyTorch等主流框架,轻松嵌入现有项目。

6. 分布式训练支持:高效支持多节点、多GPU的分布式深度学习任务。

7. 模型压缩:提供模型压缩功能,通过剪枝、量化等方法减小模型尺寸,提高推理效率。

DeepSpeed的特点

DeepSpeed的特点主要体现在以下几个方面:

1. 显著提升训练效率和内存利用率:通过ZeRO技术、混合精度训练等策略,DeepSpeed能够显著减少训练时间和内存占用。

2. 支持多种分布式训练策略:提供灵活的数据并行、模型并行和混合并行等策略,适应不同规模和复杂度的模型训练需求。

3. 优化超大规模模型的训练:DeepSpeed特别擅长处理具有大量参数的大数据模型,使得在有限计算资源下训练超大规模模型成为可能。

4. 易集成和易用性:与PyTorch等主流框架紧密集成,提供易用的API和丰富的文档支持,降低学习成本。

DeepSpeed的适用人群

DeepSpeed适用于以下人群:

1. 研究人员和工程师:需要训练大规模深度学习模型的研究人员和工程师可以通过DeepSpeed提高训练效率和模型性能。

2. 开发者和数据科学家:在自然语言处理、计算机视觉等领域工作的开发者和数据科学家可以利用DeepSpeed加速模型训练和推理过程。

3. 中小企业和独立研究人员:DeepSpeed的开源特性和易用性使得中小企业和独立研究人员也能够训练具有超过1000亿个参数的模型。

DeepSpeed使用常见问题

在使用DeepSpeed过程中,可能会遇到以下常见问题:

1. 版本不兼容问题:在安装DeepSpeed时,可能会遇到与其他依赖库(如PyTorch、CUDA等)版本不兼容的问题。解决方法是确保安装了与DeepSpeed兼容的依赖库版本,并参考官方文档进行配置。

2. 配置文件错误:在配置DeepSpeed的训练环境时,可能会因为配置文件中的参数设置错误导致训练失败。解决方法是仔细检查配置文件中的参数设置,特别是关键参数如train_batch_size、gradient_accumulation_steps和zero_optimization等。

3. 模型保存和加载问题:在使用ZeRO优化时,可能会遇到模型保存和加载的问题。解决方法是使用DeepSpeed提供的save_checkpoint和load_checkpoint方法保存和加载模型,并确保配置文件和保存时的配置一致。同时,注意恢复ZeRO的状态以避免潜在问题。

针对以上问题,建议用户在使用DeepSpeed前仔细阅读官方文档和社区提供的教程和解决方案,以确保项目的顺利进行。

相关导航

LLM聊天机器人

Coze

字节推出的AI机器人和智能体创建平台

AgentGPT

基于LLM的AI智能体

Lobe

机器学习模型训练工具

Imagen

AI图像生成模型

Ollama

开源的AI和ML工具平台

HuggingFace

小白秒变开发大神

序列猴子

超大规模的语言模型

暂无评论...