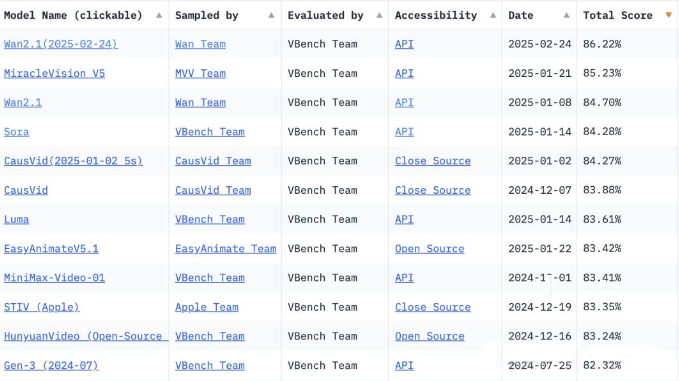

近日,阿里巴巴再度展现其在人工智能领域的深厚实力,深夜悄然开源了最新的视频生成模型——Wan 2.1。该模型一经推出,便迅速在VBench榜单上崭露头角,以其出色的性能超越了众多竞争对手,如Sora、Gen-3等,引发了业界的广泛关注与讨论。

Wan 2.1拥有高达140亿(14B)的参数规模,使其在处理复杂视频生成任务时游刃有余。从官方提供的Demo中可以看到,即便是五个人一起跳hip-hop这样的高难度场景,Wan 2.1也能精准捕捉并呈现出动作同步、细节丰富的视频效果。更为值得一提的是,Wan 2.1还成功攻克了静态图像生成中文字处理的难题,如今在视频中生成文字也显得游刃有余,且文字会根据所处位置的材质进行合理变化,与载体一同运动,呈现出极高的真实感。

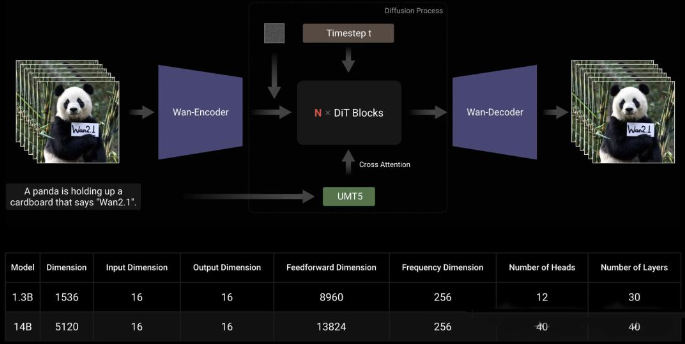

除了14B版本外,阿里还贴心地推出了一个参数量为13亿(1.3B)的小号版本,以支持更多个人创作者的使用。该小号版本支持分辨率达到480P的视频生成,在一块4090显卡上的显存占用仅为8个多GB,生成时间也仅需4分21秒。这意味着,即便没有高端硬件设备的个人创作者,也能轻松上手使用Wan 2.1进行视频创作。

此外,阿里还同步上线了两个图生视频模型,均为14B参数规模,但分别支持480P和720P分辨率的视频生成。这四个模型均采用了Apache 2.0开源协议,即允许免费商用,这无疑为AI创作者们提供了更加广阔的应用空间。

从技术层面来看,Wan 2.1采用了主流的DiT(Diffusion Transformer)架构,通过T5编码器对多语言文本进行编码,并在每个Transformer块内加入交叉注意力机制,将文本嵌入到模型架构中。同时,该模型还采用了线性层和SiLU层来处理输入时间嵌入,并预测六个调制参数。这样的MLP在所有Transformer块之间共享,每个块都学习一组不同的偏差,从而提高了模型的训练效率和生成质量。

在编码方面,Wan 2.1采用了专门为视频生成设计的3D变异自动编码器,该编码器在卷积模块中实现了特征缓存机制,并结合了多种策略来改善时空压缩,减少记忆使用情况并确保时间因果关系。这使得Wan 2.1在处理视频序列时能够更加高效、稳定。

为了提升模型的扩展性和训练效率,阿里还采用了多种分布式策略对Wan 2.1进行优化。在推理阶段,通过CP(上下文并行性)进行分布式加速,使得多卡环境下生成单个视频的延迟大大降低。

随着Wan 2.1的开源和免费商用政策的推出,相信将会有越来越多的AI创作者加入到这个大家庭中来,共同探索视频生成领域的无限可能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...