近日,人工智能领域的新星DeepSeek通过其备受瞩目的“开源周”活动,再次向业界展示了其卓越的技术实力和创新能力。从2月24日至2月28日,DeepSeek连续五天开源了五个项目,其中前三个项目——FlashMLA、DeepEP和DeepGEMM,已经在业界引起了广泛关注和热烈讨论。

DeepSeek的“开源周”活动以极致压榨英伟达芯片性能为主题,每个开源项目都旨在提高AI性能效率。FlashMLA是针对英伟达Hopper架构GPU的高效MLA(多头潜在注意力)解码内核,它优化了可变长度序列的处理,显著提高了大型语言模型推理时的效率和吞吐量。这一开源项目对于需要低延迟响应的应用,如聊天机器人、翻译服务和语音助手等,具有重要意义。

紧接着,DeepSeek开源了DeepEP,这是首个用于MoE(混合专家)模型训练和推理的开源EP(专家并行)通信库。DeepEP能够加速和改善计算机或GPU之间在处理复杂机器学习任务时的通信,特别是在涉及混合专家模型时。它就像一个聪明的交通管理员,确保所有数据能够按时、高效地传递给正确的“专家”,从而大大提高了系统的整体性能和速度。

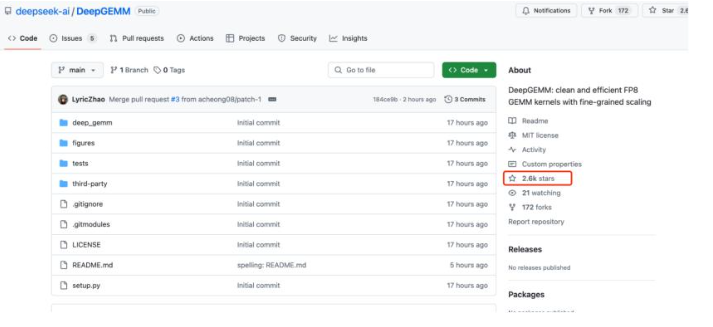

而在“开源周”的第三天,DeepSeek又放出了大招——DeepGEMM,一个支持稠密和MoE模型的FP8计算库。DeepGEMM能够动态优化资源分配,显著提升算力效率。它利用FP8(8位浮点数)进行计算,大幅减少了存储和计算的开销,同时通过两级积累方法解决了精度问题。DeepGEMM的设计简洁而高效,核心逻辑仅约300行代码,却能在大多数矩阵尺寸下优于经过专家调优的内核。这一开源项目在GitHub上发布不到10个小时,就已经获得了2.6千个星星,足以证明其受欢迎程度和技术实力。

通过这一系列开源项目,DeepSeek有效地驳斥了此前关于其在训练成本上“撒谎”的言论。事实上,DeepSeek一直强调其高效训练的秘诀是多种创新的结合,包括MoE混合专家架构和MLA多头潜在注意力技术等。这些技术在DeepSeek的开源项目中得到了深度优化和展示,让业界对其技术实力有了更深的认识和了解。

DeepSeek的“开源周”活动不仅展示了其技术实力,也为业界带来了新的思考和启示。在人工智能领域,开源已经成为一种趋势和潮流,它能够促进技术的交流和共享,推动整个行业的进步和发展。而DeepSeek作为这一趋势的引领者之一,无疑将继续在业界发挥重要作用。

随着“开源周”活动的深入进行,DeepSeek还将带来更多令人期待的开源项目。这些项目不仅将进一步展示DeepSeek的技术实力和创新能力,也将为业界带来更多的惊喜和收获。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...